Datendumps

Datendumps

Bibliotheken wie die Staatsbibliothek zu Berlin (SBB) stellen in der Regel drei Arten von Daten zur Verfügung: Texte (OCR aus digitalisierten Büchern oder Manuskripten), Metadaten und Bilder (Scans von Büchern, Abbildungen, die im gescannten Material enthalten sind, oder andere).

Hier werden beispielhaft Datensets aufgelistet, die für Nutzer:innen in unterschiedlichen Zusammenhängen von Interesse sein können. Grundsätzlich gilt immer die Eingangsseite der Digitalisierten Sammlungen als Ausgangspunkt.

Volltexte, Metadaten und Bilder

Die Absicht bei der Erstellung dieses umfassenden Datensatzes war es, Forschung auf der Grundlage von Volltexten zu erleichtern, die in der Staatsbibliothek zu Berlin (SBB) verfügbar sind. Diese Volltexte werden in der Regel über eine Implementierung optischer Zeichenerkennung (OCR) der Bücher in den digitalisierten Sammlungen der Staatsbibliothek erzeugt. Dort können die Volltexte auch manuell und einzeln, Werk für Werk, heruntergeladen werden. Die Veröffentlichung eines Satzes von etwa 5 Millionen OCR-Seiten erleichtert die Zugänglichkeit der Volltexte und macht ein distant reading eines goldenen Topfs voller Texte möglich.

Der Datensatz enthält sämtliche am 21. August 2019 in den digitalisierten Sammlungen der Staatsbibliothek zu Berlin verfügbaren Volltexte.

Umfang:

4.998.099 Seiten, die zu 28.909 einzelnen Werken gehören (identifizierbar über die Pica Production Number ppn) als Datendump (ca. 17 GB).

Spezifika:

Der Datensatz enthält keinerlei Annotationen.

Die folgenden Vorverarbeitungsschritte wurden durchgeführt:

– die Extraktion der OCR-Ergebnisse aus den ALTO.xml-Dateien, die durch die OCR-Pipeline erzeugt wurden

– der Abgleich der eindeutigen Identifikatoren (PPNs, Pica Production Number), die für einzelne digitalisierte Werke verwendet werden, mit den ALTO.xml-Dateinamen, die die Ausgabe jeder einzelnen verarbeiteten Seite enthalten

– die Bereitstellung von Metriken (Konfidenz, Entropie) bezüglich der Sprache(n), die auf jeder Seite zu finden sind

Lizenzen:

Ansprechpartner:

Zenodo DOI:

Materialien:

Metadaten stellen eine wenig erforschte Ressource dar, was sehr zu bedauern ist: Diese Metadaten sind von hoher Qualität, da sie von geschulten Bibliothekaren, Archivaren oder anderen Fachleuten des kulturellen Erbes erstellt wurden. Die Veröffentlichung eines Datensatzes, der mehr als 200.000 Zeilen Metadaten umfasst, zielt daher darauf ab, eine wenig erforschte, qualitativ hochwertige Art von Daten in gebündelter Form nutzbar zu machen. Der hier vorgelegte Datensatz wurde aus den METS-Dateien erzeugt, die bei der Digitalisierung eines jeden Werks angelegt werden; sie wurden in ein Tabellenformat konvertiert.

Der Datensatz besteht aus einer einzigen csv-Tabelle (kommaseparierte Werte, UTF-8 kodiert), die Metadaten aller 206.411 Werke enthält, die am 23. Januar 2023 in den digitalisierten Sammlungen der Berliner Staatsbibliothek (SBB) verfügbar waren.

Umfang:

206.411 Metadatensätze (csv) als Datendump (ca. 216 MB).

Spezifika:

Der Datensatz enthält keine Annotationen, die über die in den METS-Quelldateien verfügbaren Informationen hinausgehen.

Der einzige Vorverarbeitungsschritt, der durchgeführt wurde, ist die Konvertierung der METS-Datensätze in das .csv-Format. Dies beinhaltet die von mods4pandas durchgeführten Bereinigungsprozesse, die sich aus der Umwandlung eines hierarchischen Formats (METS/MODS) in ein Tabellenformat ergeben.

Lizenzen:

Ansprechpartner:

Zenodo DOI:

Materialien:

Der Datensatz umfasst deskriptive Metadaten zu 2.619.397 Titeln, die zusammen den „Alten Realkatalog“ der Staatsbibliothek zu Berlin bilden. Die Daten sind im Tabellenformat gespeichert und umfassen 375 Spalten. Sie wurden im Dezember 2023 aus dem deutschen Bibliotheksverbundsystem (CBS) heruntergeladen. Exemplarische Aufgaben, die mit diesem Datensatz bearbeitet werden können, sind Studien zur Buchgeschichte zwischen 1500 und 1955, zur paratextuellen Formatierung wissenschaftlicher Bücher zwischen 1800 und 1955 und zur Mustererkennung auf der Basis bibliographischer Metadaten.

Umfang:

2.619.397 Metadatensätze im Format .parquet als Datendump (ca. 960 MB).

Spezifika:

Der Datensatz enthält keine Annotationen. Die Daten für die 2,6 Millionen Titel wurden aus dem im CBS verfügbaren Format in ein Tabellenformat konvertiert, wobei jedes im CBS verfügbare Feld eine Spalte bildet.

Lizenzen:

Ansprechpartner:

Zenodo DOI:

Materialien:

Diese Metadaten-Veröffentlichung kann als deutsche Nationalbibliografie für den Zeitraum 1500–1800 betrachtet werden. Sie besteht aus zwei Dateien: Die erste enthält alle bibliografischen Stammdatensätze der im deutschen Sprachraum zwischen 1500 und 1800 erschienenen Drucke, wie sie im Verbundkatalog K10plus publiziert wurden, d.h. der gemeinsamen Datenbank des Bibliotheksservice-Zentrums Baden-Württemberg (BSZ) und der Verbundzentrale des GBV (VZG). Die zweite Datei listet die eindeutigen Identifikatoren („Pica-Produktionsnummer”) aller im Verbundkatalog K10plus verfügbaren Stammdatensätze derjenigen Werke auf, die digitalisiert wurden, und sie enthält die Links zu ihren digitalen Kopien. Das Ziel dieser Datenveröffentlichung war die Bereitstellung großer, maschinell verarbeitbarer Datensätze, die ausschließlich aus bibliografischen Metadaten bestehen. Damit soll zum einen die Forschung und Entwicklung von KI-Anwendungen angeregt werden, zum anderen eine Grundlage für eine komputationelle Auswertung verfügbarer Daten zur deutschen Buchgeschichte zwischen 1500 und 1800 bereitgestellt werden.

Der Datensatz besteht aus zwei Tabellen im Format .parquet. Sie enthalten die Metadaten aller im VD16, VD17 und VD18 aufgelisteten Stammdatensätze, die im Februar 2025 im K10plus verfügbar waren.

Umfang:

750.342 Metadatensätze in der Bibliographie („VD-Bib-Metadata.parquet“, ca. 487 MB), 590.528 Metadatensätze in der Digitalisate-Auflistung („VD-Digi-Metadata.parquet“, ca. 105 MB).

Spezifika:

Der Datensatz enthält keine Annotationen, die über die im K10plus verfügbaren Informationen hinausgehen.

Lizenzen:

Ansprechpartner:

Zenodo DOI:

Materialien:

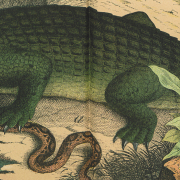

Diese Datenveröffentlichung wurde mit dem Ziel erstellt, einen einzigen großen, annotierten Computer Vision-Datensatz zu Forschungszwecken und zur Entwicklung von KI-Anwendungen bereitzustellen. Die Datenveröffentlichung umfasst 53.533 Illustrationen, die aus 3.412 Kinder- und Jugendbüchern extrahiert wurden, die zwischen 1800 und 1925 veröffentlicht wurden.

Das Hauptziel dieser Datenveröffentlichung war die Bereitstellung eines großen, komputationell verarbeitbaren Datensatzes, der ausschließlich aus Bilddateien besteht, um die Forschung und Entwicklung von KI-Anwendungen anzuregen. Im Jahr 2025 fehlen noch immer große (Meta-)Datensätze aus dem Bereich der historischen Kulturdaten. In dieser Hinsicht soll die hier bereitgestellte Datenveröffentlichung eine Lücke schließen. Die Dateien eignen sich für die komputationelle Nutzung digitalisierter Sammlungen gemäß den Prinzipien von „Collections as Data”.

Umfang:

53.533 jpg-Dateien in 3.412 Ordnern in einem zip-Container („ColibriImagesDataset.zip“, ca. 44,6 GB), 53.533 Metadatensätze inklusive Annotationen in einer csv-Datei („ColibriMetadataAnnotations.csv“, ca. 22 MB), Beispielbilder für jede annotierte Klasse in einer pdf-Datei („ColibriExamplesForTheImagesInTheDataset.pdf“, ca. 10 MB).

Spezifika:

Der Datensatz enthält Annotationen, die den Metadaten teils manuell, teils automatisch hinzugefügt wurden.

Lizenzen:

Ansprechpartner:

Zenodo DOI:

Materialien:

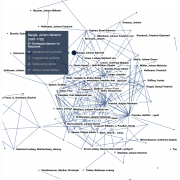

Historische Zeitungssammlungen gehörten zu den ersten Materialien, die gescannt wurden, um sie für die Zukunft zu bewahren. Um die Möglichkeiten zur Suche, Erforschung und Analyse bestimmter Arten von Informationen aus digitalisierten Zeitungen zu erweitern, müssen geeignete Technologien entwickelt werden. Named Entity Recognition (NER) und Entity Linking (EL) sind solche Techniken zur Informationsextraktion, die darauf abzielen, benannte Entitäten, insbesondere Eigennamen, zu erkennen, zu klassifizieren, zu disambiguieren und zu verknüpfen. Große annotierte Datensätze für historische Zeitungen sind jedoch nach wie vor selten. Um das Training von Machine-Learning-Modellen zu ermöglichen, die benannte Entitäten korrekt identifizieren und mit Normdateien wie z. B. Wikidata-Entitäten verknüpfen können, stellen wir ein Korpus von 100 deutschsprachigen Zeitungsseiten zur Verfügung, die zwischen 1837 und 1940 veröffentlicht wurden. Die Machine-Learning-Aufgabe, für die dieser Datensatz gesammelt wurde, fällt in den Bereich der Token-Klassifizierung und, allgemeiner, der Verarbeitung natürlicher Sprache.

Umfang:

100 tsv-Dateien in einem zip-Container („ZEFYS2025.zip“, ca. 2,1 MB).

Spezifika:

Der Datensatz enthält manuelle Annotationen von 4.389 Entitäten der Klasse PER, 6.049 Entitäten der Klasse LOC und 3.223 Entitäten der Klasse ORG.

Lizenzen:

Ansprechpartner:

Zenodo DOI:

Materialien:

Ein im Rahmen des OCR-D-Projekts erstellter Ground-Truth-Datensatz (GT), bestehend aus 348 Seiten, die aus historischen Dokumenten des „Verzeichnis der im deutschen Sprachraum erschienenen Drucke“ (VD) extrahiert wurden und sämtlich von der Staatsbibliothek zu Berlin (SBB) digitalisiert wurden.

Die Datenveröffentlichung besteht aus 348 XML-Dateien mit Transkriptionen für 348 TIF-Faksimile-Bilddateien. Die Bilddateien wurden aus 67 verschiedenen Werken ausgewählt; aus 65 Werken wurden je vier Bilder extrahiert; aus zwei weiteren Werken wurden 49 bzw. 39 Bilder extrahiert, um die GT zu erstellen.

Der Datensatz wird durch eine CSV-Datei ergänzt, die eine Zuordnung zwischen den in diesem Datensatz verwendeten Identifikatoren und den eindeutigen Identifikatoren (Pica-Produktionsnummer PPN) in den digitalisierten Sammlungen der Staatsbibliothek zu Berlin enthält, sowie durch eine Dateiliste im CSV-Format.

Umfang:

348 PAGE-XML-Dateien sowie 348 TIF-Dateien in einem zip-Container („OCR-D-VD-SBB.zip“, ca. 797 MB), Mapping zwischen den im Datensatz verwendeten Identifikatoren und den PPNs in den Digitalisierten Sammlungen als csv-Datei („MappingDirectoryName-PPN.csv“, 8 kB), Dateiliste als csv-Datei („OCR-D-GT-VD-SBB-filelisting.csv“, 39 kB).

Spezifika:

Der Datensatz enthält sowohl Auszeichnungen der Textregionen und ihrer Labels auf der jeweiligen Einzelseite als auch manuell transkribierte GT mit einer Zeichengenauigkeit von 99,95%.

Lizenzen:

Ansprechpartner:

Zenodo DOI:

Stand: 06.11.2025

Public Domain

Public Domain